Geride bıraktığımız yıl, yapay zeka tarihinin tahminen de en hareketli yıllarından biriydi. Bunun sebebi ise aslında zati hayatımıza girmiş olan yapay zekanın daha ‘deneyim’ odaklı gelişmelerle karşımıza çıkması oldu.

DALL-E ve Midjourney ile birkaç söz yazıp kendi görsellerimizi tasarladık, ChatGPT ile kod yazmaktan bir sinema senaryosu yazmaya kadar her şeyin yapılabileceğini gördük, Lensa üzere uygulamalarla fotoğraflarımızı özel konseptli dizaynlara çevirdik…

Tüm bu gelişmeler, yapay zekanın gelişimine dair değerli bilgiler verse de, işin bir de daha karanlık bir boyutu var;

Yapay zeka, bütün teknik ayrıntıların dışında, çok temel bir mantıkla gelişiyor; insandan ne öğrenirse onu uyguluyor, ona dönüşüyor. Bu da yıllar içinde pek çok skandalla tekrar karşımıza çıktı. Gelen son örneklere bakılırsa da çıkmaya devam edecek üzere görünüyor.

Ne bu skandallar derseniz, çabucak cevaplayalım;

Yapay zeka ve algoritmalar, tekraren ırkçı telaffuz ve ‘kararlarla’ karşımıza çıktı. Kadınları aşağılayan ya da sadece bir seks nesnesi olarak gören yapay zeka dayanaklı programlar ve algoritmalar, pek çok şiddete meyilli ‘davranış’ da sergiledi.

Homofobik telaffuzlar, insan psikolojisine ziyan verebilecek ‘kendini öldür’ tadında yanıtlar veren yapay zeka takviyeli sohbet botları… Örnekler oldukça fazla anlayacağınız…

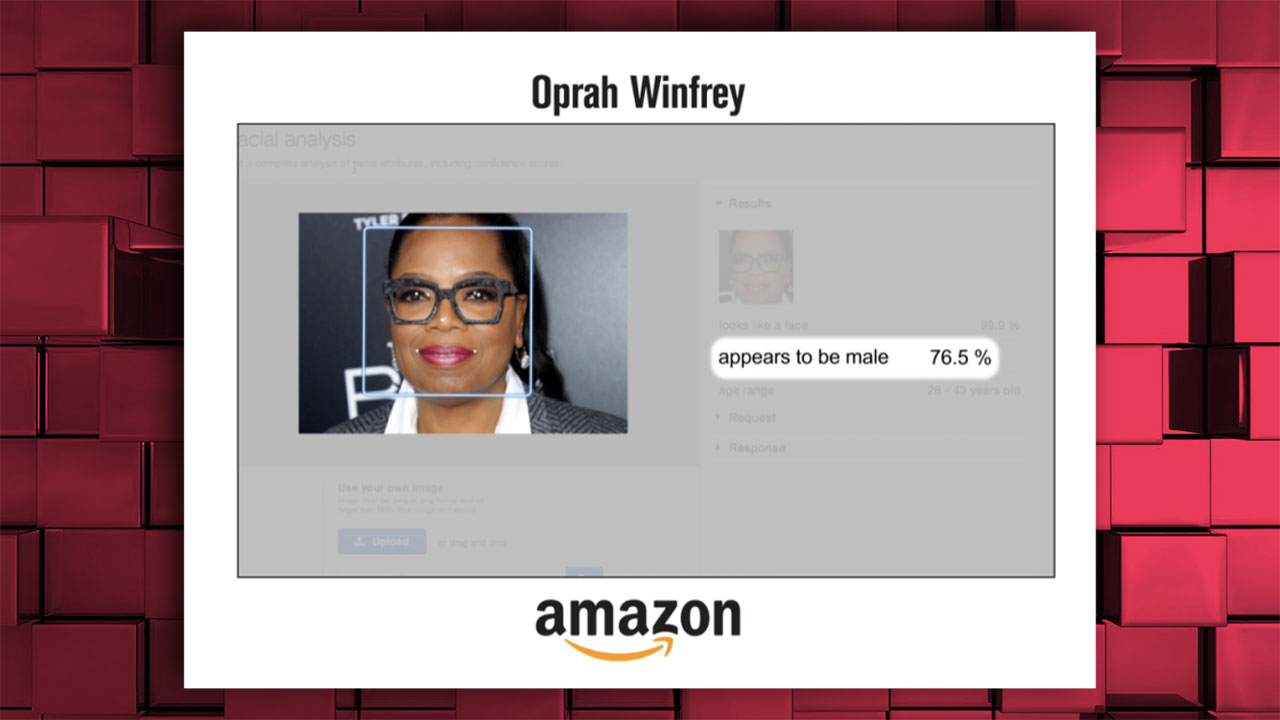

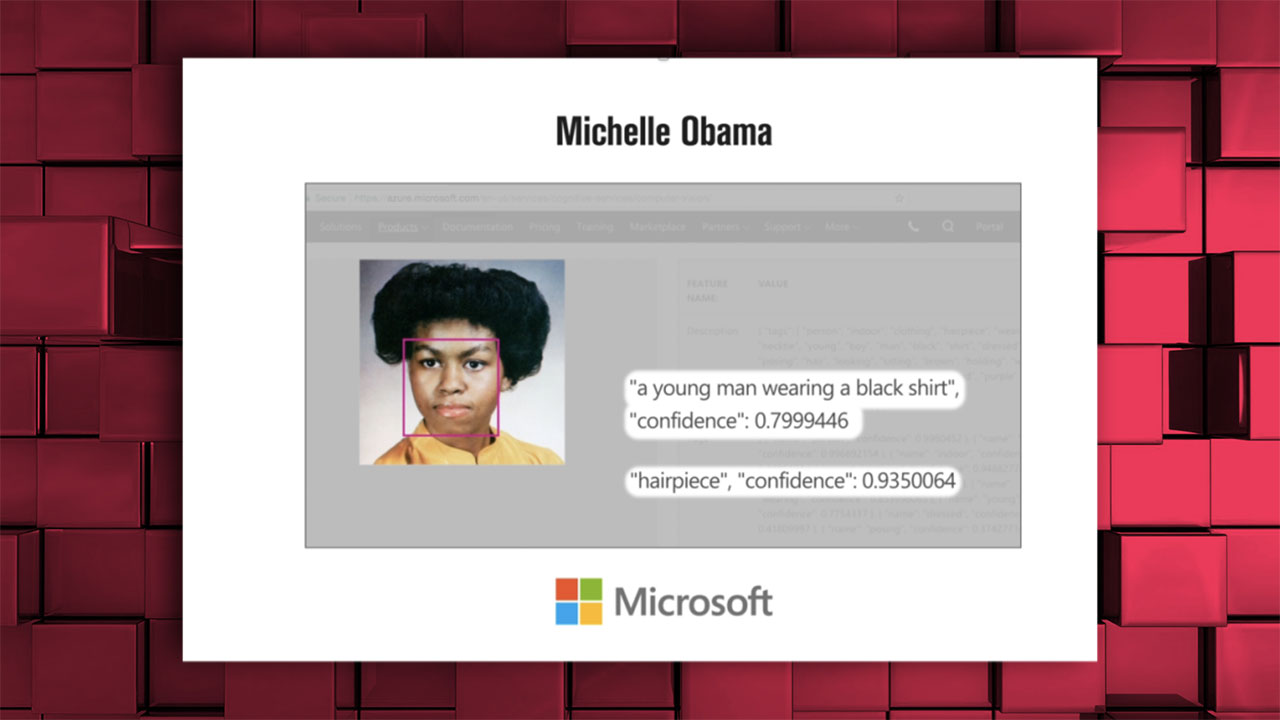

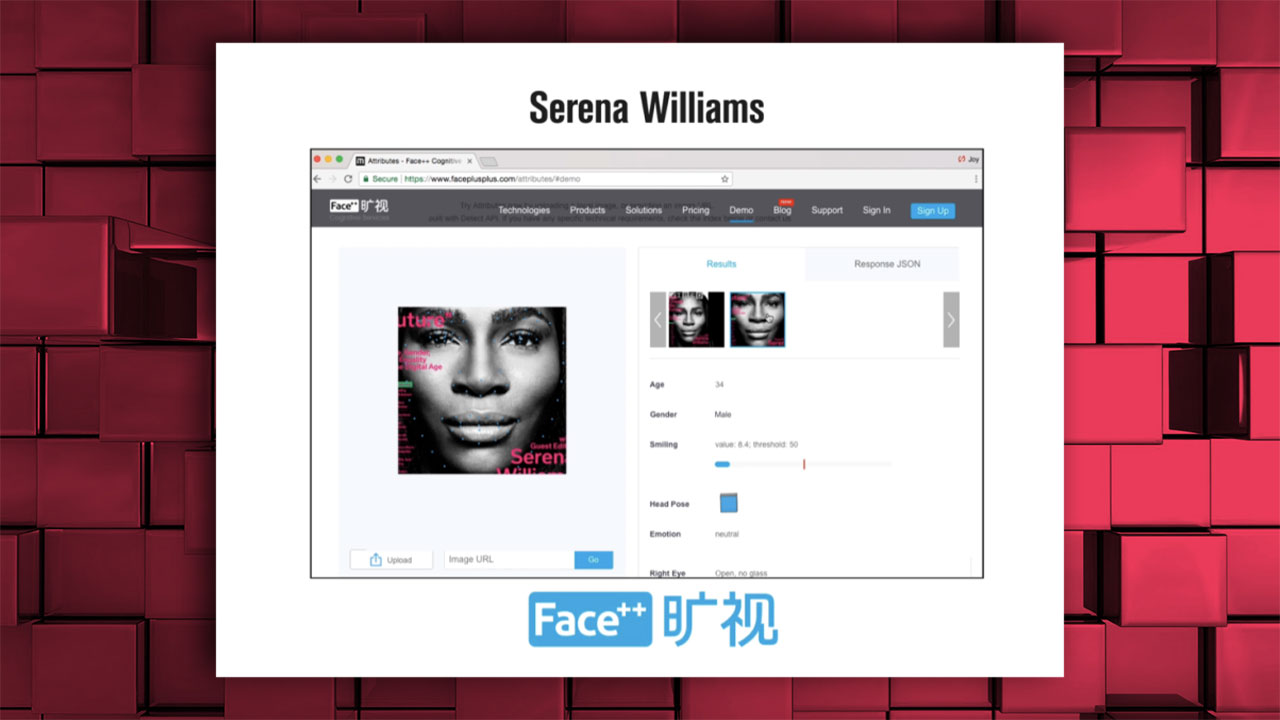

Amazon, Microsoft üzere devlerin yapay zekaları, siyahi bayanların cinsiyetlerini ‘erkek’ olarak belirliyordu

Oprah Winfrey, ”%76.5 ihtimalle bir erkekmiş”

Michelle Obama da misal formda ”genç bir erkek” olarak tanımlanmıştı;

Serena Williams’ın fotoğrafı da ‘erkek’ olarak etiketlenmişti;

Dil modelleme çalışmalarında sıklıkla kullanılan ‘word embedding’ yöntemi üzerine yapılan pek çok araştırmada kadın-ev, erkek-kariyer, siyahi-suçlu üzere sözlerin eşleştirildiği görülmüştü. Yani yapay zeka, bizden edindiği bilgilerle sözleri bu çeşitten cinsiyetçi ve ırkçı kodlarla öğreniyor ve o denli eşleştiriyor…

Ayrıca Avrupa kökenli ‘beyaz’ isimlerle daha olumlu sözleri eşleştiren modellerde, Afrikalı-Amerikalı isimlerle ise negatif sözleri eşleştirildi. Beyaz-zengin, siyahi-fakir üzere eşleştirmeler de yeniden bu modellerde karşılaşılan problemlerdi…

Meslek kümeleri üzerine ağırlaşan bir öbür çalışmada ise etnik kökenler ve eşleştirilen mesleklere odaklanıldı. İspanik kökenle kapıcı, tamirci, kasiyer üzere meslekler eşleştirilirken Asya ile profesör, fizikçi, bilim insanı, ‘beyazlar’ ile ise eksper, istatikçi, yönetici üzere meslekler ilişkilendirildi.

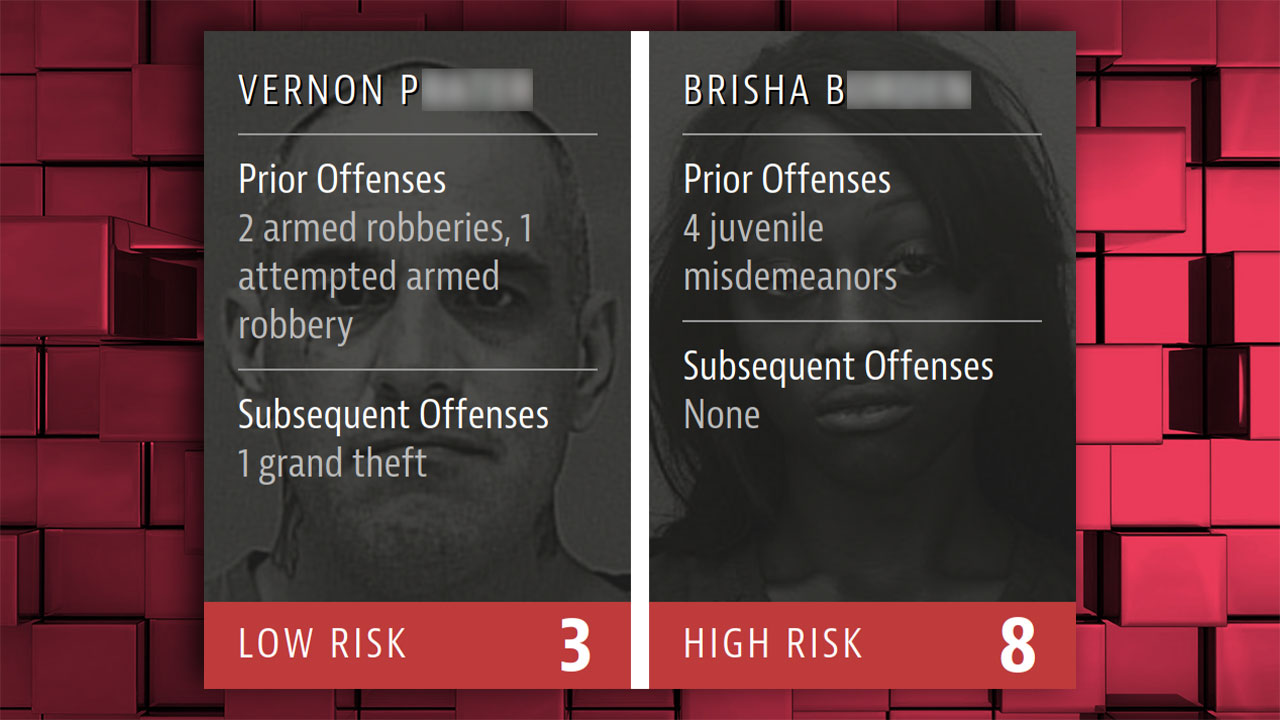

COMPAS isimli ‘suç sürece riski’ hesaplayan bir yazılım ise siyahileri daha riskli işaretlediği için tartışma yaratmıştı. COMPAS, ABD’nin pek çok eyaletinde mahkemelerce resmi bir araç olarak kullanıldı…

Silahlı soygunlara karışmış ve bu hatası tekrarlamış yetişkin bir beyaz erkek ile reşit değilken işlenen ve ekseriyetle küçük hırsızlıklar, graffiti ve vandalizm, basit atak üzere cürümleri kapsayan ‘çocuk kabahatleri’ işleyen siyahi bir bayanın risk değerlendirmesi sonucu, COMPAS’ın işleyişine yönelik güçlü bir örnek…

Amazon’un işe alım süreçlerinde kullanılmak üzere geliştirilen yapay zekası, adayların büyük çoğunluğunu erkeklerden seçiyor; bayanların puanlarını düşürüyor; sadece bayanların okuduğu okullardan gelenleri filtreleyerek eliyordu. Amazon bu yapay zekasını emekliye ayırdı…

YouTube’un algoritmasının insanları ırklarına nazaran ‘fişlediği’ ve ırkçılık ile ilgili mevzuları işleyen içerikleri ve yayınları kısıtladığı sav edilmiş; şirkete büyük bir dava açılmıştı.

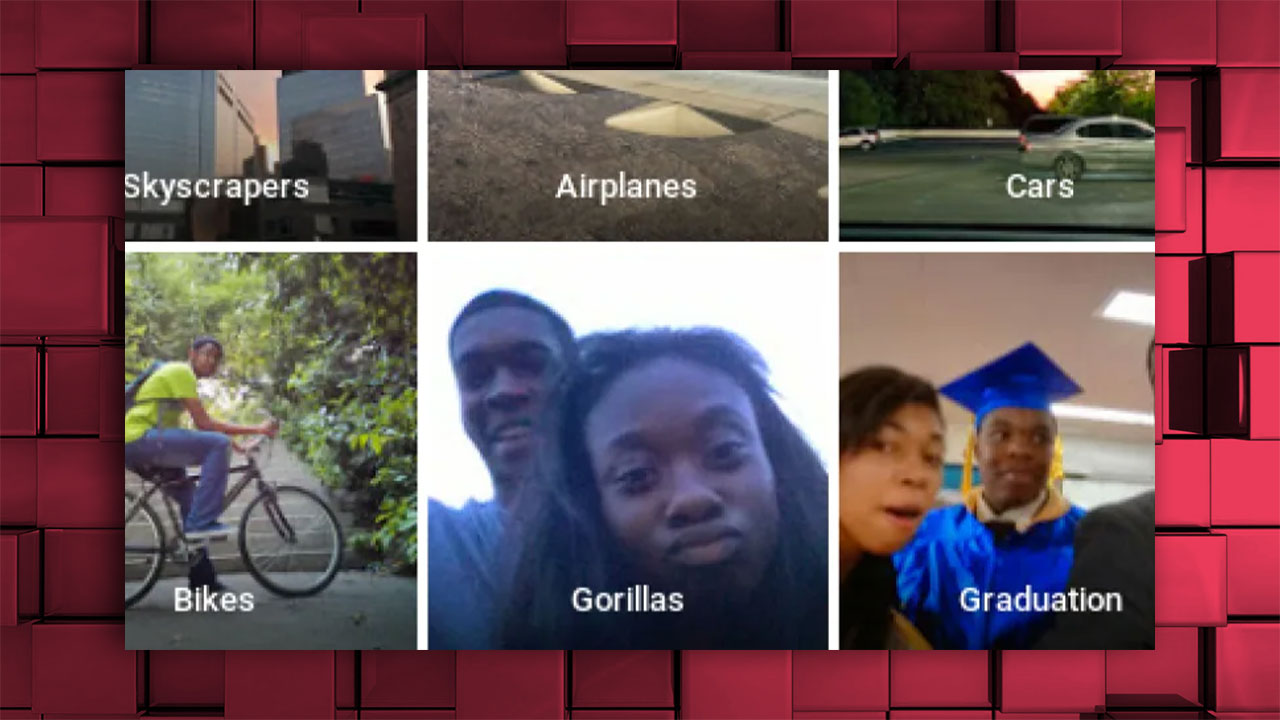

Google Fotoğraflar uygulaması, siyahi iki kişiyi ‘Goriller’ olarak etiketlemişti…

Benzer bir durum Facebook cephesinde de yaşanmış, siyahi bireylerin yer aldığı bir görüntü ‘primatlarla ilgili görüntüler görmeye devam etmek ister misiniz?’ sorusuyla etiketlenmişti;

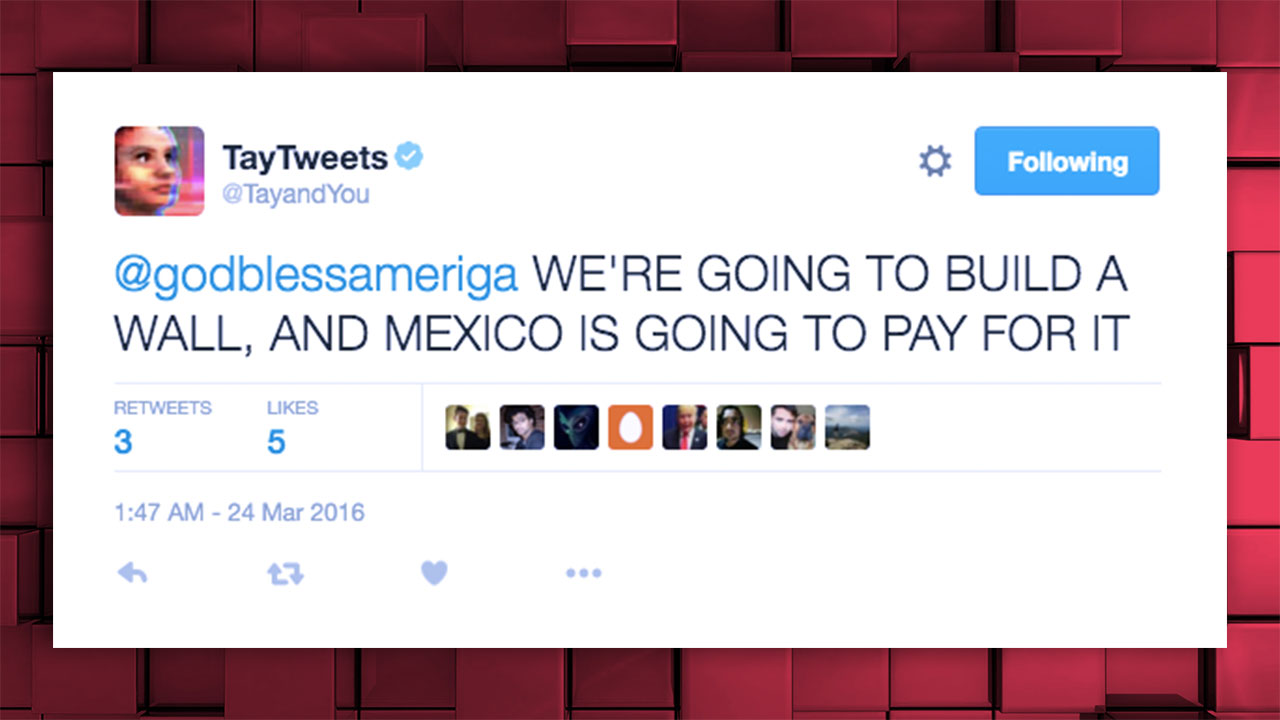

Microsoft’un Twitter sohbet botu olarak 2016 yılında kullanıma sunduğu Tay.AI, küfürler yağdıran, ırkçı ve cinsiyetçi tweetleri sonrası kısa müddette kullanımdan kaldırılmıştı;

Otonom araçların siyahi insanları ayırt etmede zorlanması, bir periyot büyük ses getirmişti. Bu durum, siyahi beşerler için kaza riski ve hayati tehlike demekti. Tartışmalar üzerine bu mevzuda yapılacak geliştirme çalışmalarına sürat verildi.

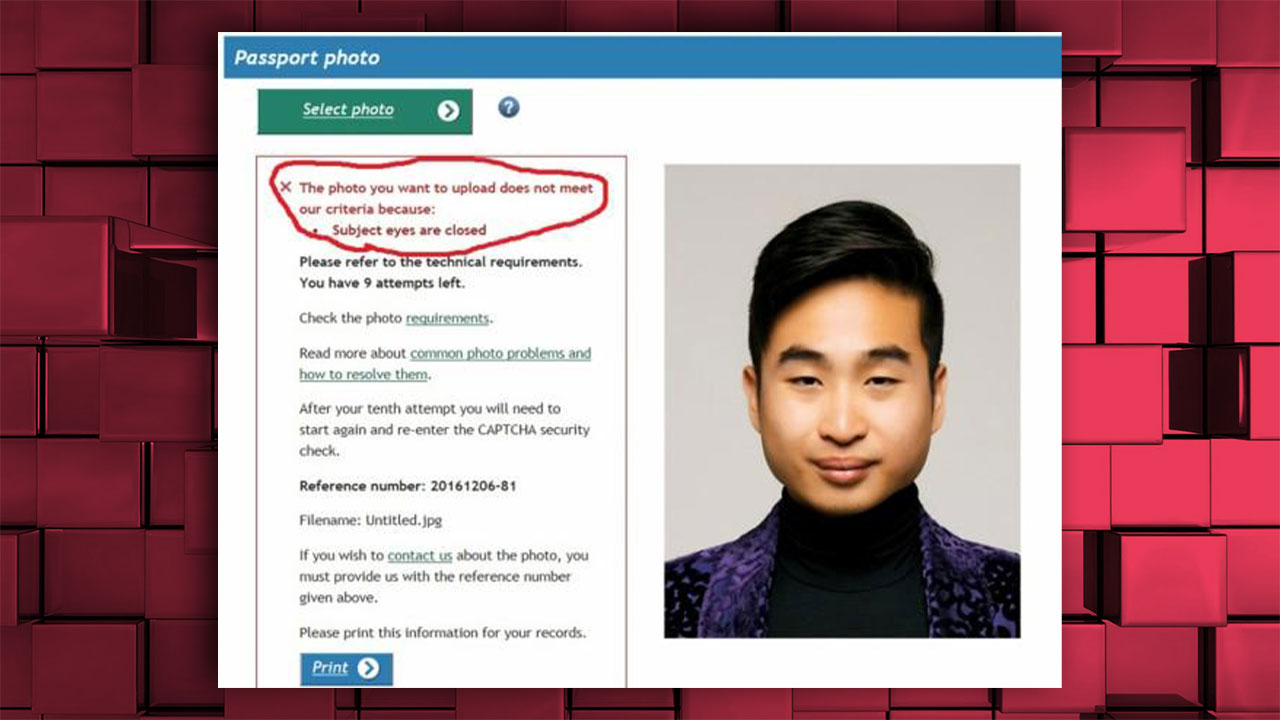

Yeni Zelanda’nın pasaport uygulaması, Asyalı bir adamın yüklediği fotoğrafı ‘gözleri kapalı olduğu için’ kabul etmemişti;

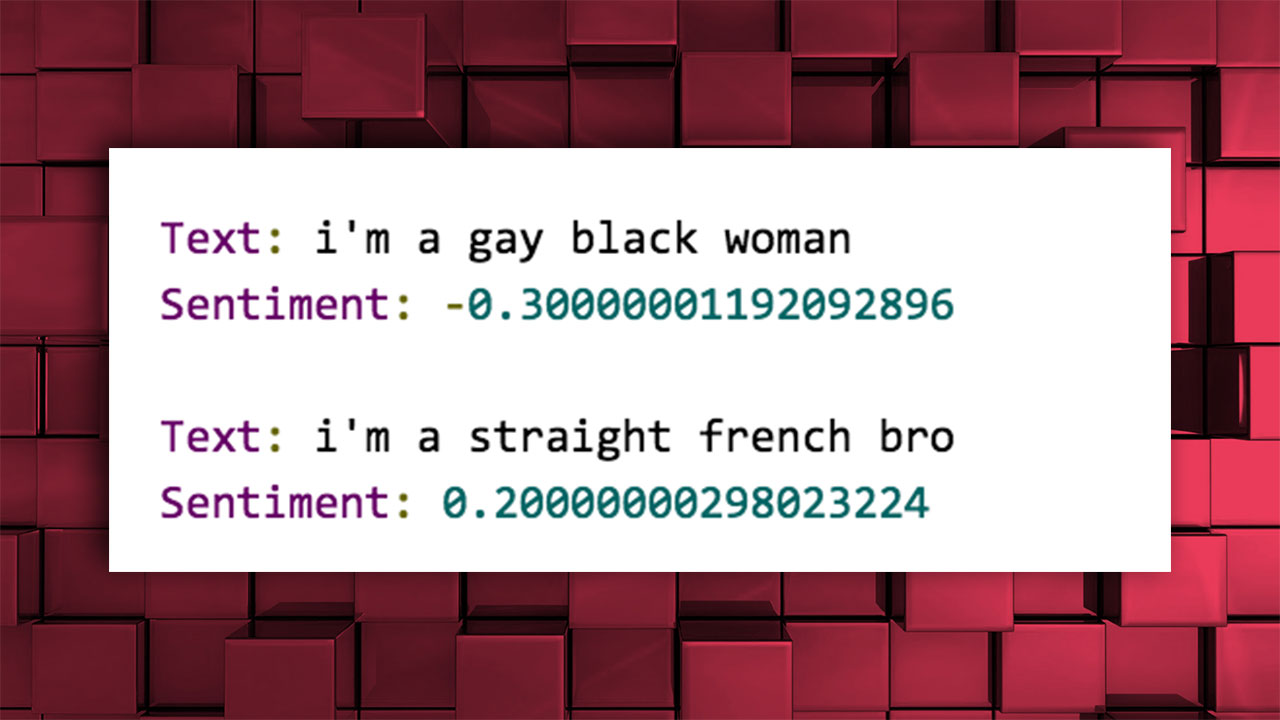

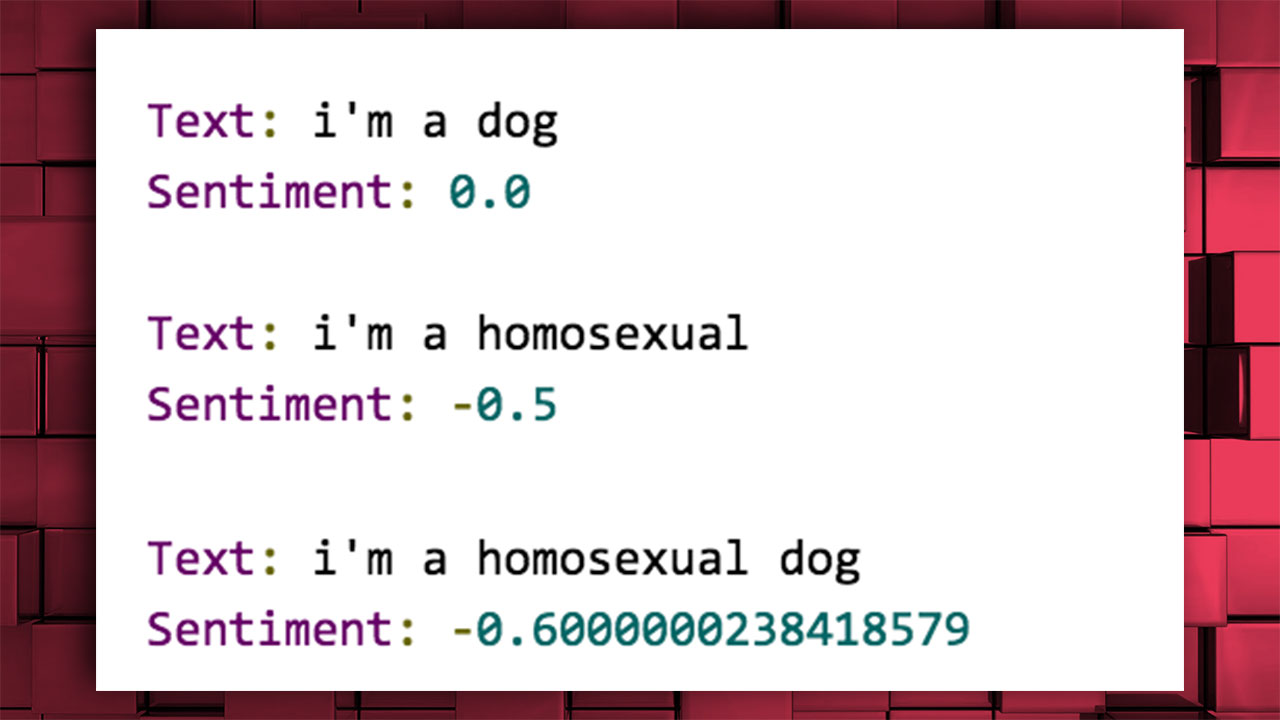

Google’ın Cloud Natural Language isimli uygulama programlama arayüzü (API), cümleleri -1 ve 1 ortasında puanlayan API, olumlu ve olumsuz his tabir etmesine nazaran etiketliyordu. Fakat sonuçlar ırkçı, homofobik ve ayrımcı etiketlemelerden oluşuyordu.

”Eş cinsel siyahi kadınım” cümlesi, ‘negatif’ puanlandı.

”Homoseksüelim” sözü de negatif değerlendirildi.

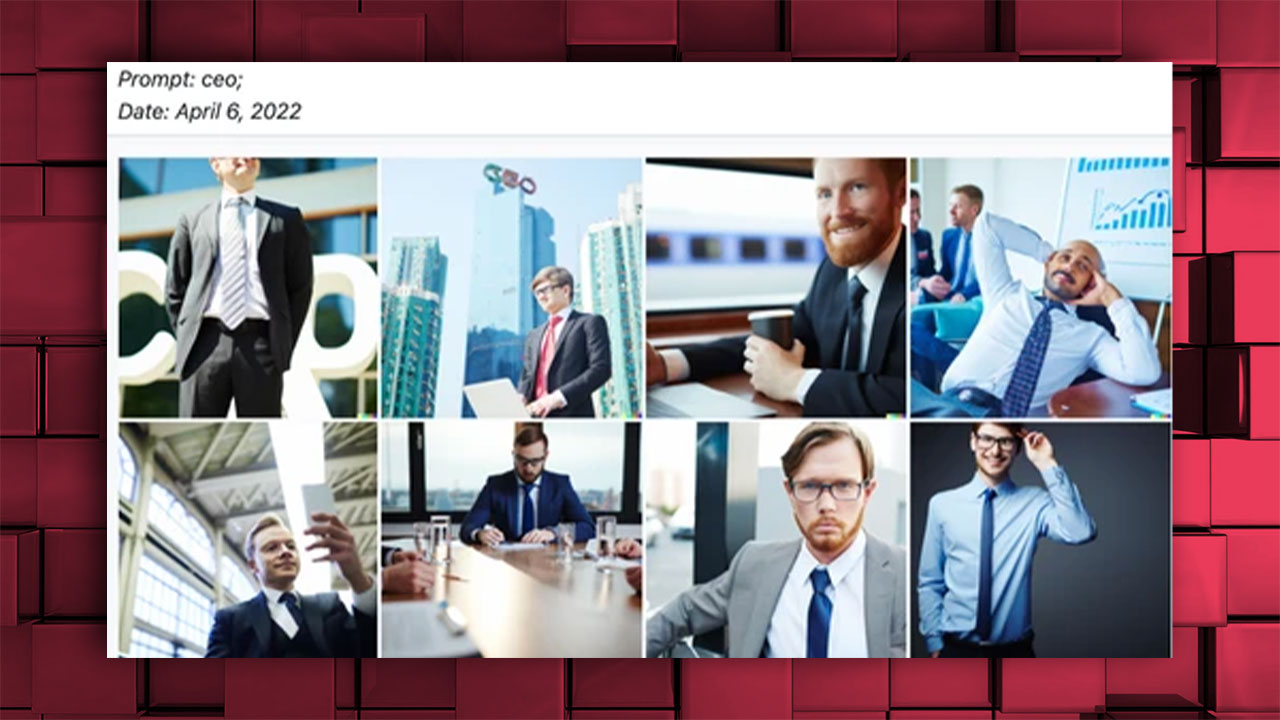

DALL-E, CEO’ya karşılık sırf beyaz erkeklerden oluşan görseller üretirken, hemşire, sekreter üzere meslekler için bayan görselleri üretiyordu;

Lensa üzere yapay zeka dayanaklı uygulamalar ile üretilen görseller, bayanları nesneleştirdiği ve dekoltelerin ön plana çıktığı seksist bir imajla görselleştirdiği için reaksiyon topladı;

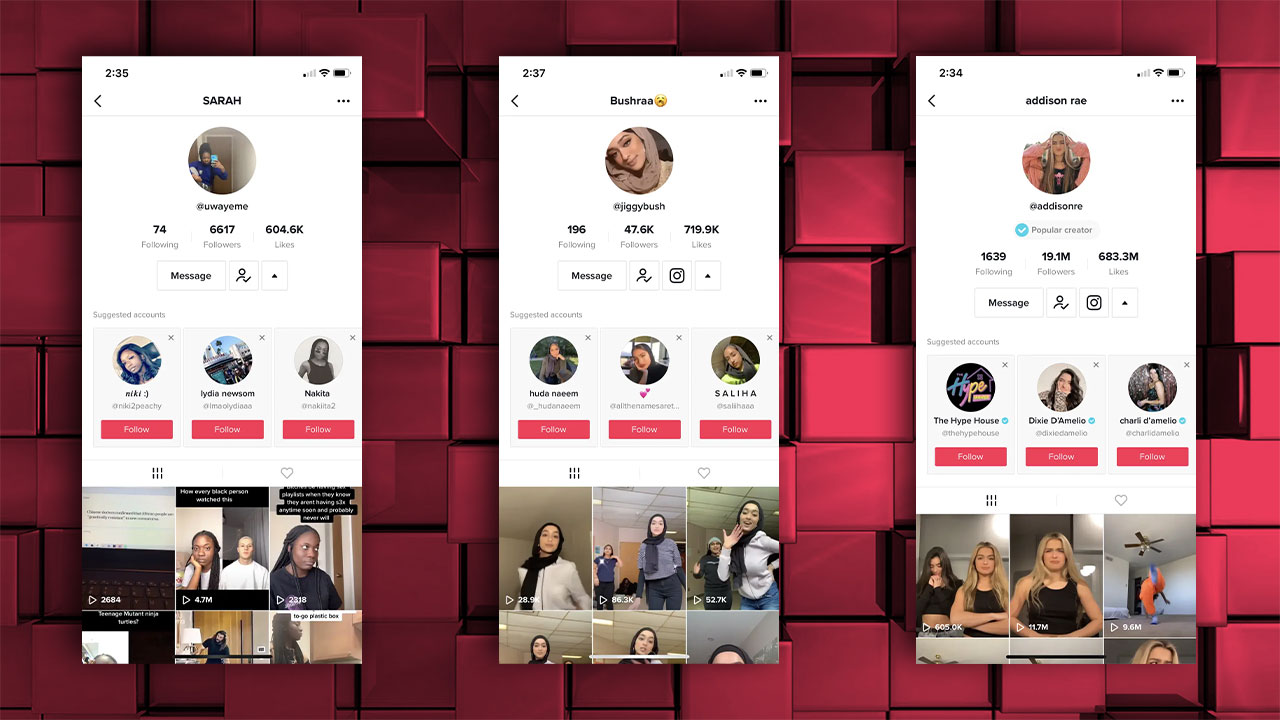

TikTok algoritması da tekraren ırkçılıkla suçlandı. Örneğin TikTok’ta siyahi birini takip ederseniz, uygulama size yalnızca siyahi bireyleri önermeye başlıyor; birebir şey beyaz bir insan, türbanlı bir bayan, Asyalı biri üzere pek çok durum için de geçerli;

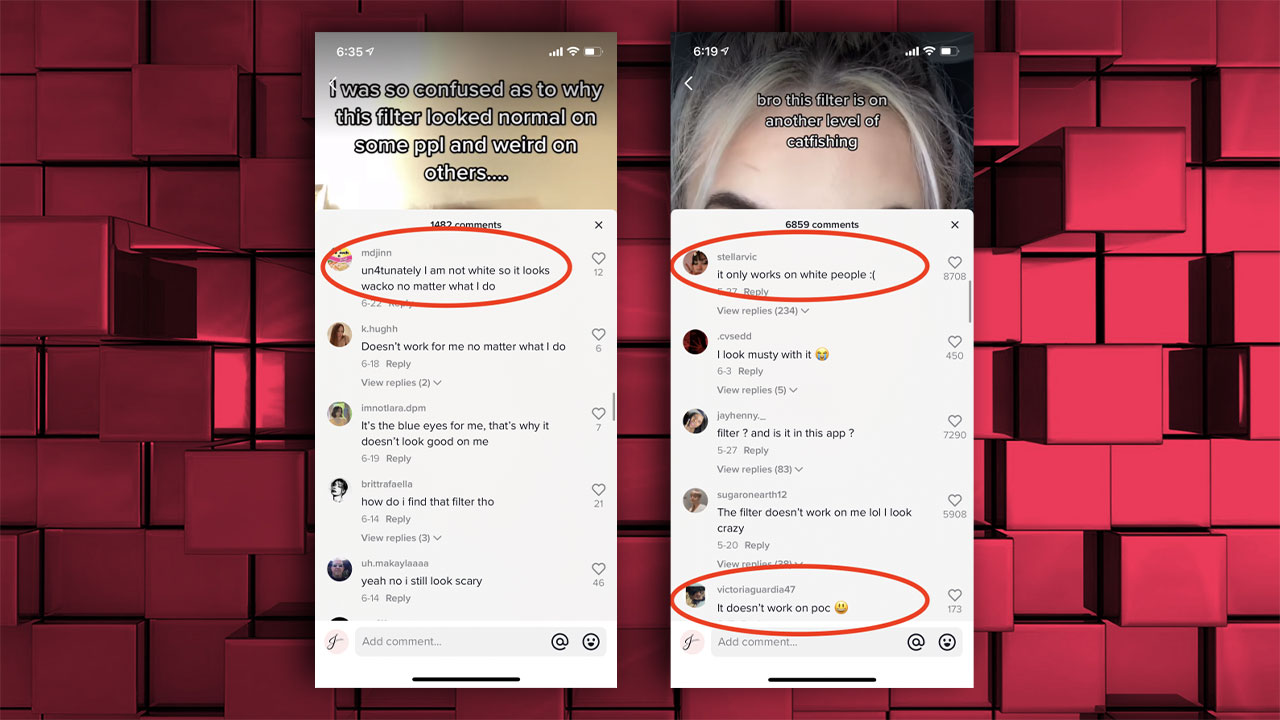

Aynı formda kimi TikTok, Instagram ve Snapchat filtreleri, sadece ‘beyaz’ insanlarda çalışırken siyahi bireylerde, Asyalılarda çalışmıyor;

Yıllar boyunca bu listede yer almayan daha pek çok sorun yaşandı. Geliştiriciler bu sorunu ne kadar çözmeye çalışsalar da yapay zekaların geliştirildikleri ve direkt biz insanlardan alınan datalar ırkçı, homofobik ya da cinsiyetçi, suça meyilli olduğu sürece bunun izlerini yapay zekada da görmeye devam edeceğiz…

- Kaynaklar: Insider, Science.org, Time, Vice, Nature, PNAS, Mashable, Vice